|

| Einstein mit zerzaustem Haar. |

(Beitrag editiert am 5.4: Zusammenfassung etwas detaillierter erklärt und Schaubild zur Normalverteilung ergänzt)

Bevor wir aber zurück zu Einsteins Haaren und der Entropie kommen, möchte ich noch kurz was zu meiner Überschrift sagen. Die Aussage von Karl Marx, mit dem dialektischen Materialismus die Dialektik Hegels vom "Kopf auf die Füße" zu stellen ist ziemlich bekannt. Weniger bekannt ist aber die Aussage von Hegel, auf die sich Marx dort bezieht:

"Daß das natürliche Bewußtsein sich der Wissenschaft unmittelbar anvertraut, ist ein Versuch, den es, es weiß nicht von was angezogen, macht, auch einmal auf dem Kopfe zu gehen; der Zwang, diese ungewohnte Stellung anzunehmen und sich in ihr zu bewegen, ist eine so unvorbereitete als unnötig scheinende Gewalt, die ihm angemutet wird, sich anzutun. – Die Wissenschaft sei an ihr selbst, was sie will; im Verhältnisse zum unmittelbaren Selbstbewußtsein stellt sie sich als ein Verkehrtes gegen dieses dar; oder weil dasselbe in der Gewißheit seiner selbst das Prinzip seiner Wirklichkeit hat, trägt sie, indem es für sich außer ihr ist, die Form der Unwirklichkeit"

(Quelle: G.W.F. Hegel - "Die Phänomenologie des Geistes", Werkausgabe S. 30, fett von mir)

Die Physik ist der Teilbereich der Wissenschaft, wo das von Hegel Gesagte wohl am Deutlichsten zu Tage tritt. Für die Relativitätstheorie und die Quantemechanik müssen wir die Vorstellungen des "natürlichen Bewusstseins" von der Beschaffenheit von Raum und Zeit, von der Beschaffenheit der kleinsten Teilchen, aufgeben und uns ganz auf die Gedankengänge (auch in Form mathematischer Formalismen) einlassen. Unsere Intuition, unsere "natürlichen" Vorstellungen, scheinen diesen Erklärungen oft zu widersprechen. Auf den ersten Blick dürfte die (moderne) Physik wohl jedem "verkehrt" oder "unwirklich" vorkommen. Einstein etwa, war so gut mit Maxwells Elektromagnetismus vertraut, war so sehr von der Stimmigkeit der Theorie überzeugt, dass er eher bereit war die Vorstellungen von Raum und Zeit als Maxwells Gleichungen aufzugeben. Ohne einen sicheren (Kopf-)Stand in der Theorie des Elektromagnetismus wäre Einstein mit Sicherheit nie auf die Idee gekommen, an den Vorstellungen über Raum und Zeit zu zweifeln. Das Einstein keine "unwirklichen", realitätsfernen Spinnereien produziert hat, zeigen heute ganz praktische Errungenschaften wie der Laser, der in jedem DVD Laufwerk steckt (vgl. Albert Einstein - "Strahlungsemission und Absorption nach der Quantentheorie") oder die Tatsache, dass GPS nur unter Berücksichtigung der Zeitdilatation der Relativitätstheorie funktioniert. Das soll nun nicht heißen, dass Intuition oder Vorstellungsvermögen was Schlechtes sind, im Gegenteil, denn letztlich war es Einsteins Intuition, die ihn zur Relativitätstheorie geführt hat, sondern es geht eher um die Position, von der aus man sich von der Intuition leiten lässt. Und in der Wissenschaft ist es - Marx mag widersprechen soviel er will - nun mal besser "auf dem Kopf zu gehen".

Kommen wir aber zu Erik Verlinde. Verlinde ist Stringtheoretiker und Stringtheoretiker sind geradezu Meister darin, auf dem Kopf zu gehen. Stringtheorie hat mit Physik eigentlich nicht mehr wirklich was zu tun, sondern ist eher ein mathematischer Spielplatz in dem Theoretiker - auf dem Kopf gehend - herumtollen und Ideen ausprobieren in der Hoffnung eine "unterlegte" einfachere Theorie zu finden (vgl. M-Theorie). Verlinde ist von dieser ungewohnten Haltung aus aufgefallen, dass man die lange Geschichte von Newtons Apfel und den Gesetzen der Dampfmaschine bis hin zur Thermodynamik Schwarzer Löcher andersherum betrachten könnte. In seiner Publikation "On the Origin of Gravity and the Laws of Newton" stellt er quasi die Thermodynamik schwarzer Löcher von den Füßen auf den Kopf und plötzlich erscheinen komplizierte Zusammenhänge relativ einfach. Naja, wirklich "einfach" ist es noch nicht, aber zumindest so einfach, dass man seine Ideen ohne Einblick in die "Abgründe" der Stringtheorie, in Grundzügen nachvollziehen kann. Um seine Ideen zu verstehen, muss man aber dennoch ein paar Grundlagen kennen und ich denke, dass ich es schaffen werde, diese Grundlagen anschaulich - ganz ohne Kopfstand - zu erklären. Und zu den Grundlagen der "entropic gravity" gehört natürlich die Entropie, mit der ich beginnen will.

1.1 Entropie und der zweite Hauptsatz der Thermodynamik

Möchte man die Geschichte der Gravitationstheorie beschreiben, dann wird häufig mit Isaac Newton und seiner Apfelanekdote begonnen. In diesem Artikel fange ich aber bei Sadi Carnot und der Dampfmaschine an. Wir wissen heute, dass Wärme äquivalent zu Energie ist und die thermische Energie sich in (mechanische) Arbeit umwandeln lässt. Zur Zeit der Erfindung der Dampfmaschine war dies aber nicht bekannt. Wärme würde als eine Art Stoff betrachtet. Sadi Carnot war in seiner wegweißenden Schrift "Betrachtungen über die bewegende Kraft des Feuers und die zur Entwickelung dieser Kraft geeigneten Maschinen (1824)" selbst noch dieser Ansicht. Aus seinem Nachlass geht aber hervor, dass Carnot der erste war, der die Äuqivalenz von Wärme und Energie erkannte. Die Thermodynamik war geboren, die physikalische Grundlage für heute so alltägliche Dinge wie die Motoren in Autos oder die Wärmepumpen in Kühlschränken war gegeben. Der Carnot-Prozess und der im Zusammenhang stehende Carnot-Wirkungsgrad sind heute nach Sadi Carnot benannt.

Die Arbeiten Carnots und der Energieerhaltungssatz von Julius Robert von Mayer brachte Rudolf Clausius zusammen. Clausius war der Erste, der den 2. Hauptsatz der Thermodynamik formulierte:

"Es gibt keine Zustandsänderung, deren einziges Ergebnis die Übertragung von Wärme von einem Körper niederer auf einen Körper höherer Temperatur ist."

Was bedeutet das im Klartext? Nehmen wir ein einfaches Beispiel. In einem Zimmer herrscht eine Temperatur von 20°C und es gibt einen Heizkörper mit der Temperatur von 25°C. Was passiert? Nun die Heizung gibt Wärme an das Zimmer ab. Die Temperatur des Heizkörpers sinkt (sofern dem Heizkörper keine neue Wärme zugeführt wird) während die Temperatur im Zimmer steigt. Anders ausgedrückt: die Temperaturdifferenz zwischen Heizkörper und Zimmer sinkt. Der zweite Hauptsatz besagt nun, dass es "von alleine" eben nur in diese "Richtung" geht und die Temperaturdifferenz nicht "von alleine" steigen kann. Also, dass das kältere Zimmer mit seinen 20°C keine Wärme an den wärmeren Heizkörper mit 25°C abgeben kann und das Resultat nachher ein Zimmer mit beispielsweise 18°C und eine Heizung mit 27°C sein kann. Zumindest nicht spontan, also ohne Zutun.

Würde man alleine nur den Energieerhaltungssatz (den 1. Hauptsatz der Thermodynamik) betrachten, wäre dies theoretisch möglich. Das Zimmer gibt einen gewissen Grad an Energie in Form von Wärme an den Heizkörper ab und der Heizkörper nimmt diese Energie in Form von Wärme auf. Die Gesamtenergie würde erhalten bleiben.

Ganz vereinfacht, sagt der 2. Hauptsatz also nichts anderes, dass Wärme immer vom wärmeren zum kälteren Körper fließt und nicht andersherum. Also, dass etwas kälteres nichts Wärmeres noch weiter aufheizen kann.

Wie ist das dann aber bei einem Kühlschrank? Dort wird doch die Wärme im Kühlschrank an den Raum abgegeben. Dort wird in der Tat Wärme von einem kälteren Ort an einen wärmeren Ort transportiert, aber das passiert eben nicht "von alleine". Der Kühlschrank braucht dafür Strom. Die Erhöhung der Temperaturdifferenz ist eine Folge der verrichtet Arbeit, durch die Wärmepumpe. Die Heizung braucht eine solche Pumpe nicht, die Wärme verteilt sich von ganz alleine.

Diese zwei Beispiele von Heizung und Kühlschrank dürfte jedem einleuchten. Wärme fließt von Warm nach Kalt, wie Wasser von oben nach unten fließt. Anstatt zu sagen, dass Wärme von "warm" nach "kalt" fließt, sagt man auch, dass die Entropie zunimmt. Der Begriff Entropie wurde in diesem Zusammenhang von Clausius eingeführt. Möchte man aber verstehen warum, das so ist und möchte man verstehen was Entropie ist und warum sie ständig von alleine zunimmt, wird es im Zusammenhang mit Thermodynamik deutlich schwerer. Ich war auf dem technischen Gymnasium und hatte dort Thermodynamik als Fach und unser Lehrer hat gemeint, dass wir gar nicht erst versuchen sollen, zu verstehen, was Entropie ist. Bei der Erklärung der Entropie wird diese häufig mit "Unordnung" erklärt. Es gibt dazu zwar stimmige Konzepte (vgl. entropy (disorder and order)), dazu muss aber "Unordnung" sehr genau definiert werden, was dem Verständnis nicht gerade hilft. Ein Beispiel dafür, weshalb der Begriff "Unordnung" problematisch ist, findet sich etwa hier und eine ausführliche Auseinandersetzung mit der Problematik des Begriffs der Unordnung findet man in der Publikation "Disorder - A Cracked Crutch for Supporting Entropy Discussions" von Frank Lambert.

Wer also schon grobe Vorstellungen von Entropie als ein Maß der Unordnung hat, sollte das schleunigst vergessen. Ich denke, dass man Entropie nicht nur mit sehr einfachen Mitteln und Beispielen anschaulich verstehen, sondern dass man sogar die Formel mit Mathematikkenntnissen auf Mittelstufenniveau herleiten kann. Dazu müssen wir aber einen Sprung machen von den Teilchenbewegungen in einer Dampfmaschine zu den Bits und Bytes in einem Computer.

1.2 Entropie und die Informationstheorie

""My greatest concern was what to call it. I thought of calling it ‘information’, but the word was overly used, so I decided to call it ‘uncertainty’. When I discussed it with John von Neumann, he had a better idea. Von Neumann told me, ‘You should call it entropy, for two reasons. In the first place your uncertainty function has been used in statistical mechanics under that name, so it already has a name. In the second place, and more important, nobody knows what entropy really is, so in a debate you will always have the advantage."

(Quelle:Claude Shannon nach: M. Tribus, E.C. McIrvine Energy and information, Scientific American, 224 (September 1971), S. 180, fett von mir)

Ich habe gerade erst schon geschrieben, dass mein Lehrer davon abriet, Entropie verstehen zu wollen und auch die Aussage von John von Neumann klingt nicht gerade ermutigend. Dass aber niemand wirklich weiß, was Entropie wirklich ist, hat von Neumann natürlich auch mit einem ironischen Unterton gesagt und da die "Von Neumann-Entropie" nach ihm benannt ist, kann man davon ausgehen, dass er sehr genau wusste was Entropie ist. Kommen wir aber zu der Person, der von Neumann den Rat gegeben hat, seine Entdeckung Entropie zu nennen. Die Rede ist von Claude Shannon, dem Begründer der Informationstheorie. Shannon hat auf den Rat von von Neumann gehört und seine Entdeckung Entropie genannt und man spricht manchmal auch von Shannon-entropie. Ich möchte jetzt aber nicht auf Shannons Arbeit "A Mathematical Theory of Communication" eingehen, sondern wie versprochen, Entropie so einfach wie möglich erklären. Dazu kommen wir zu einem Beispiel, das ich bei Statistik gerne heranziehe: Ein Münzwurf.

Ein Münzwürf ist eine einfache Sache. Die Chance ist fifty-fifty, je 50% oder $\frac{1}{2}$, dass Kopf oder Zahl kommt. Ich möchte jetzt eine Art Messgröße für einen Münzwurf einführen. Diese Messgröße nenne ich vorest mal Ungewissheit. Wenn ich eine (faire) Münze werfe, dann ist erst mal ungewiss ob Kopf oder Zahl kommt. Ich habe also "Ungewissheit". Im Gegenzug hätte ich bei einer gezinkten Münze die auf beiden Seiten Kopf zeigt, keine "Ungewissheit". Ich weiß dann von vornherein, dass Kopf kommt. Die Frage ist nun, wie ich Ungewissheit messen soll? Ich habe das Beispiel Münzwurf nicht umsonst gewählt, denn es gibt die zwei Lösungsmöglichkeiten Kopf oder Zahl. Damit habe ich ein sehr naheliegende Einheit für das Maß der Ungewissheit, nämlich Bit. Da wir im Computerzeitalter die Maßeinheit für Information sowieso am ehesten in Bit angeben, ergibt es Sinn, Ungewissheit als die Menge an unbekannte Information in Bit zu verstehen. Ein Bit kann $0$ oder $1$ annehmen. Ich kann also nun Kopf mit $0$ und Zahl mit $1$ identifizieren. Die Ungewissheit für einen Münzwurf wäre also 1 Bit. Bei zwei Münzwürfen wäre dann meine Ungewissheit entsprechend 2 Bit. Wir könnten nun also eine einfach Formel angeben: Ungewissheit = Anzahl der Münzwürfe.

Wenn wir uns aber nochmal den Fall der Münze ansehen, die immer Kopf anzeigt, dann ist diese einfache Formel problematisch. Das Ergebnis ist ja immer Kopf oder $0$. Das Wichtige aber ist, dass wir nur messen wollen, wieviel Information uns nicht bekannt ist. Wir wissen aber das Ergebnis schon im Voraus. Unsere Ungewissheit ist also 0 Bit. Bei obiger Formel würde aber 1 Bit nach einem Wurf herauskommen. In unsere Formel müssen wir also mehr berücksichtigen.

Wie können wir also Unterscheiden, wann Ungewissheit vorliegt und wann nicht? Wir sollten hierzu einen Blick auf die Kombinationsmöglichkeiten werfen. Wenn ich die faire Münze einmal werfe, dann gibt es zwei Kombinationsmöglichkeiten Kopf und Zahl (fortan mit K und Z abgekürzt) oder $0$ und $1$, werfe ich die Münze zweimal, dann gibt es vier Kombinationsmöglichkeiten: KK, KZ, ZK, ZZ oder in 2 Bit ausgedrückt: $00$, $01$, $10$, $11$. (Anmerkung: Wenn ich hier von Kombinationsmöglichkeiten spreche, dann meine ich immer die Kombinationsmöglichkeiten in der selben Reihenfolge wie sie nach dem Werfen auftreten. Danke YooBee für das Kommentar.) Werfe ich die Münze drei mal, dann sind es schon 8 Kombinationen. Die Kombinationsmöglichkeiten sind also aus den Münzwürfen zu berechnen. Für $N$ Münzwürfe gibt es $2^N$ Kombinationsmöglichkeiten.

Schauen wir uns nun die Münze an, bei der auf beiden Seiten Kopf ist. Bei einem Wurf gibt es nur ein Kombinationsmöglichkeit: K oder $0$. Bei zwei Würfen ist es immer noch nur eine Kombinationsmöglichkeit, nämlich KK oder 00. Bei 3 wäre es dann KKK oder 000 usw.

Damit wäre uns also sehr geholfen. Bei nur einer Kombinationsmöglichkeit sind es 0 Bit, bei zwei Kombinationsmöglichkeiten sind es 1 Bit, bei 4 sind es 2 Bit, bei 8 sind es 4 Bit usw. Wir können also sehr einfach die Kombinationsmöglichkeiten aus den Bits berechnen. Für $N$ Bits haben wir $2^N$ Kombinationsmöglichkeiten. Also $2^N=K$. Wie kommen wir nun aber von den $K$ Kombinationsmöglichkeiten zu den $N$ Bits? Man kann die Formel umstellen: $\log_2 K=N$

ACH DU SCHEISSE, LOGARITHMUS. DAS HAB ICH SCHON IN DER SCHULE NICHT KAPIERT -> Tab schließen....

STOP. Schwerer wird es nicht. $2^4$ wird wohl jeder der überhaupt soweit gelesen hat berechnen können. Logarithmus macht nichts weiter, als die Formel um zudrehen. Wenn ich wissen will, was ich für $?$ in $2^?=16$ einsetzen muss kann ich einfach den Taschenrechner zücken und $\log_2 16$ eingeben und der spuckt mir 4 aus. Mehr ist das nicht und komplizierter wird es nicht mehr. Wer es bis hier geschafft hat, der hat das Grundprinzip der Entropie schon verstanden. Zumindest für den Spezialfall einer fairen Münzen und einer Münze mit Kopf oder Zahl auf beiden Seiten, ist das schon die Formel für die Entropie. Ich nennen diesen Spezialfall jetzt die "faire Münzenentropie" $M_f=\log_2 K$ und formuliere den 2. Hauptsatz der Münzenwurfdynamik.

"Für Fortschreitendes Werfen einer fairen Münze gilt für die Änderung der fairen Münzenentropie $\Delta M_f \ge 0$"

Umso mehr Münzwürfe, umso mehr Kombinationsmöglichkeiten, umso größer die "faire Münzentropie". Nichts weiter. Zunehmende Entropie ist nichts weiter als eine Aussage über Kombinationsmöglichkeiten oder Mikrozustände in der statistischen Mechanik.

Noch eine kleine Anmerkung zur Namensgebung. Ich hatte oben noch von Ungewissheit gesprochen und habe aber diese Messgröße nun Entropie genannt. Der Grund, dass ich vorerst von Ungewissheit gesprochen habe, hat damit zu tun, dass dieser Begriff vertrauter ist. Auch Shannon wollte seine Entropieformel zuerst Ungewissheit (uncertainty - siehe Zitat am Anfang des Abschnitts) nennen und nannte es auf Rat von von Neumann Entropie. Das hat schlicht historische Gründe und ist der Namensgebung von Clausius geschuldet.

Ich werde an dieser Stelle das Ganze noch vertiefen. Wen die Mathematik bisher nicht abgeschreckt hat, der kann hier weiter lesen. Für ein grundlegendes Verständnis der Entropie, ist das aber nicht nötig und der Abschnitt 1.2.1 kann übersprungen und bei Abschnitt 1.3 weiter gelesen werden.

1.2.1 Optional: Vollständige heuristische Herleitung der Shannonentropie

Für die "faire Münzenentropie", haben wir bisher nur die Kombinationsmöglichkeiten betrachtet. Für eine ganz allgemeine Formel der Entropie reicht das aber nicht aus. Nehmen wir einen etwas komplexeren Fall für einen Münzwurf. Die Münze in folgendem Beispiel ist auf der einen Seite etwas schwerer, als auf der anderen Seite, wodurch es beim Werfen etwas wahrscheinlicher ist, dass Kopf bzw. Zahl kommt. Als Beispiel etwa eine Münze, bei der mit 60% Wahrscheinlichkeit Kopf und mit 40% Wahrscheinlichkeit Zahl kommt. Die Kombinationsmöglichkeiten ändern sich hierbei aber nicht. Die möglichen Ausgänge für zwei Würfe wären (wie bei der fairen Münze) immer noch KK, KZ, ZK und ZZ, aber die Wahrscheinlichkeit, dass KK das Resultat ist, ist höher als die Wahrscheinlichkeit, dass ZZ kommt. Unsere Ungewissheit wäre aber in einem solchen Fall geringer. Wir wissen zwar nicht wirklich wie der Ausgang eines solchen Münzwurfs ist, aber wir wissen, dass eher Kopf kommen muss. Damit unser Entropiekonzept, das ja ein Maß der Ungewissheit sein soll, stimmig ist, müsste für einen Münzwürf dieser 60%/40% Münze irgendwas zwischen 0 Bit und 1 Bit herauskommen (Das ein Computer nur in "ganzen" Bits rechnen kann, soll uns erst einmal nicht interessieren. In der Praxis wird dann einfach aufgerundet wie in diesem Beispiel beim Informatiosngehalt der mit der Shannonentropie zusammenhängt). Anstatt nur auf die Kombinationsmöglichkeiten zu schauen, müssen wir also irgendwie die Wahrscheinlichkeit berücksichtigen. Bleiben wir dazu vorerst noch bei der fairen Münzen und schauen ob wir statt der Kombinationsmöglichkeiten die Wahrscheinlichkeit verwenden können.

Um unser Konzept zu überbearbeiten, sollte wir versuchen einen Zusammenhang zwischen Kombinationsmöglichkeiten und Wahrscheinlichkeit finden. Betrachtet wir dazu mal die Wahrscheinlichkeit der Kombinationsmöglichkeiten der fairen Münzen. Nach einem Wurf sind die möglichen Kombinationen K und Z. Die Wahrscheinlichkeit $p$ für eine der Kombinationsmöglichkeiten ist $\frac{1}{2}$. Bei zwei Würfen wären es 4 Kombinationsmöglichkeiten. Jede einzelne Kombinationsmöglichkeit hat eine Wahrscheinlichkeit von $p=\frac{1}{2}\cdot \frac{1}{2} = \frac{1}{4}$. Betrachten wir dazu mal folgende Tabelle. $N$ bezeichnet die Anzahl der Münwürfe, $K$ bezeichnet die Kombinationsmöglichkeiten und $p$ bezeichnet die Wahrscheinlichtkeit für eine der Kombinationen.

$$ \begin{array}{|c|c|c|}

\hline

~~~~N~~~~ & ~~~~K~~~~ & ~~~~p~~~~ \\ \hline

1 & 2 & \frac{1}{2} \\ \hline

2 & 4 & \frac{1}{4} \\ \hline

3 & 8 & \frac{1}{8} \\ \hline

4 & 16 & \frac{1}{16} \\ \hline

\end{array}$$

Man sieht sofort, dass die Wahrscheinlichkeit der Kehrwert der Kombinationsmöglichkeiten ist, also $p=\frac{1}{K}$. Wenn jede Kombinationsmöglichkeit die gleiche Chance hat und die Summe der Wahrscheinlichkeiten 1 ist, dann ergibt sich das trivial. Wir können also für unsere faire Münzentropie $M_f$ von oben schreiben:

$$ M_f = \log_2 K = \log_2 \frac{1}{p}$$

Das bringt uns schon mal für unsere 60%-40% Münze ein kleines Stück weiter, da wir nun die Wahrscheinlichkeit drin haben, aber wir haben es noch nicht geschafft, denn die Frage ist nun, was ich bei der 60%-40% Münze denn für $p$ einsetzten soll. Soll ich $p=0{,}6$ (also 60%) oder $p=0{,}4$ (also 40%) einsetzen?

Es ist ziemlich ersichtlich, dass wir beide Wahrscheinlichkeiten berücksichtigen müssen. Nennen wir die Wahrscheinlichkeit für Kopf nun $p_K$ und die für Zahl $p_Z$, dann haben wir $p_K=0{,}6$ und $p_Z=0{,}4$. Unsere Formel müsste also irgendwie die Summe $\log_2 ~p_K + \log_2 ~p_Z $ enthalten. Man sieht aber sofort, dass dann unsere "faire Münzentropie" nicht mehr stimmen würde. Wir hätten dann $M_f = \log_2 \frac{1}{p_K} + \log_2 \frac{1}{p_Z}$ statt $M_f = \log_2 \frac{1}{p}$. Bei der fairen Münze wäre der Wert dann doppelt so groß, denn es gilt dann ja $p_K=p_Z=p$ und $M_f = \log_2 \frac{1}{p} + \log_2 \frac{1}{p} = 2 \cdot \log_2 \frac{1}{p}$. Wir brauchen also noch einen Vorfaktor. Das zuerst naheliegende bei dem doppelt so großen Wert, wäre natürlich einfach durch 2 zu teilen. Bei der fairen Münze würde dann die Formel sofort wieder stimmen. Die Formel für einen Münzwurf wäre also:

$$ M_f = \frac{1}{2} \cdot \log_2 \frac{1}{p_K} + \frac{1}{2} \cdot \log_2 \frac{1}{p_Z} $$

Schauen wir aber, was bei der 60%-40% Münze passieren würde, wenn wir $p_K=0{,}6$ und $p_Z=0{,}4$ in diese Formel einsetzen:

$$ M_f = \frac{1}{2} \cdot \log_2 \frac{1}{0{,}6} + \frac{1}{2} \cdot \log_2 \frac{1}{0{,}4} \\

= \frac{1}{2} \cdot 0{,}737 + \frac{1}{2} \cdot 1{,}322 \\

= 0{,}369 + 0{,}661 \\

= 1{,}03 $$

Das Ergebnis ist nun aber nicht zufriedenstellend. Wir hatten oben überlegt, dass bei der 60%-40% Münze unsere Ungewissheit geringer sein müsste, als bei der fairen Münze. Das Ergebnis ist aber größer als 1 Bit (wer an einen Rundungsfehler glaubt, darfs selber nachrechnen :p) . Noch schlimmer ist es, wenn wir das Ganze für die Münze berechnen die auf beiden Seiten Kopf anzeigt:

$$ M_f = \frac{1}{2} \cdot \log_2 \frac{1}{0} + \frac{1}{2} \cdot \log_2 \frac{1}{1} ~ \rightarrow ~ \infty $$

Wegen der Division durch 0 geht das Ergebnis gegen unendlich, es sollte aber 0 sein.

Um auf eine sinnvollen Formel zu kommen resümieren wir nochmal was wir getan haben. Die Formel mit den Kombinationsmöglichkeiten $K$ war noch sinnvoll. Dann haben wir $K$ durch $frac{1}{p}$ ersetzt. Im Falle der gleicher Wahrscheinlichkeiten ist das vollkommen äquivalent. Im Falle von ungleichen Wahrscheinlichkeiten ist das aber nicht äquivalent. Wir könnten aber sagen, dass wir eine Art "imaginärer Kombinationsmöglichkeiten" oder eine Art "gewichtete Kombinationsmöglichkeiten" eingeführt haben. Überlegen wir also, was das für unsere Formel bedeuten würde. Wir haben dann eine Formel die von diesen "imaginärer Kombinationsmöglichkeiten" abhängt. Bei ungleichen Wahrscheinlichkeiten treten diese "imaginärer Kombinationsmöglichkeiten" aber auch selbst mit unterschiedlicher Wahrscheinlichkeit auf. Daher sollten wir vielleicht, statt des Vorfaktors $\frac{1}{2}$ die Wahrscheinlichkeit $p_K$ bzw. $p_Z$ wählen, mit der diese "imaginärer Kombinationsmöglichkeiten" auftreten. Wir könnten also probieren ob diese Formel für einen Münzwurf funktioniert, wie wir es gerne hätten:

$$ M_f = p_K \cdot \log_2 \frac{1}{p_K} + p_Z \cdot \log_2 \frac{1}{p_Z} $$

Wenn wir in diese Formel die Werte für die faire Münze einsetzen, dann haben wir wieder den Vorfaktor $\frac{1}{2}$ da $p_K=p_Z=\frac{1}{2}$. Dort würde es also passen. Probieren wir es also für unsere 60%-40% Münze:

$$ M_f = p_K \cdot \log_2 \frac{1}{p_K} + p_Z \cdot \log_2 \frac{1}{p_Z} \\

= 0{,}6 \cdot \log_2 \frac{1}{0{,}6} + 0{,}4 \cdot \log_2 \frac{1}{0{,}4} \\

= 0{,}6 \cdot 0{,}737 + 0{,}4 \cdot 1{,}322 \\

= 0{,}442 + 0{,}529 \\

= 0{,}971$$

Das sieht doch gleich viel besser aus. Unsere Ungewissheit bei der 60%-40% Münze ist geringer als 1 Bit, aber immer noch ein gutes Stück größer als 0 Bit. Eine Ungewissheit nahe bei 1 Bit wäre auch das was ich intuitiv erwarten würde. Bei unsere Münze die auf beide Seiten Kopf hat wird dann auch 0 Bit herauskommen, da $\rm{0 \cdot \log_2 \frac{1}{0} ~ \rightarrow ~ 0}$ gegen null geht und $\rm{1 \cdot \log_2 1 = 0}$ ist. Es scheint also wir haben die richtige Formel gefunden.

Wenn wir nun die Münze zweimal werfen, dann haben wir natürlich 4 Summanden, da wir das Ganze dann mit $p_{KK}, p_{KZ}, p_{ZK}, p_{ZZ}$ für die Wahrscheinlichkeiten der Kombination KK, KZ, ZK und ZZ berechnen müssen. Da bei der fairen Münze $p_{KK}=p_{KZ}=p_{ZK}=p_{ZZ}=\frac{1}{4}$ gilt und wir 4 Summanden haben, sieht man auch sofort (wegen $\frac{1}{4} \cdot 4 = 1$), dass unsere "faire Münzentropie" von oben, in der Tat ein Spezialfall der allgemeineren Formel ist. Wir müssen jetzt einfach für jede Wahrscheinlichkeit $p_i$ mit $i=\{1,...,m\}$ den Ausdruck $p_i \cdot \log_2 \frac{1}{p_i}$ berechnen und aufsummieren. Also ergibt sich für unsere (allgemeine) Münzentropie $M$:

$$M = p_1 \cdot \log_2 \frac{1}{p_1} + p_2 \cdot \log_2 \frac{1}{p_2} + p_3 \cdot \log_2 \frac{1}{p_3} + ~...$$

Statt $+$ und $...$ schreiben die Mathematiker das lieber mit dem Summenzeichen:

$$ M = \sum\limits_i^m p_i \cdot \log_2 \frac{1}{p_i}$$

Mit den Logarithmensätzen kann man, dann noch "$\log_2 \frac{1}{p_i}$" zu "$-\log_2 ~ p_i$" vereinfachen. Also:

$$ \mathrm{M} = - \sum\limits_i^m p_i \cdot \log_2 ~ p_i$$

und schon haben wir nicht nur die allgemeine Münzentropie, sondern Shannons Informationsentropie hergeleitet. Statt $\mathrm{M}$ können wir nun $\mathrm{H}$ wie Shannon schreiben und die Formel ist die selbe Formel wie die Formel $(1)$ im Wikipedia Artikel.

Von hier aus ist es nun ein leichtes auf die "anderen" Entropien zu kommen. "Andere" ist nicht umsonst in Anführungsstriche geschrieben, denn so gesehen unterscheiden sich diese eigentlich nur in den Einheiten. Für den Zusammenhang mit der Entropie in der Thermodynamik bzw der Statistischen Mechanik brauchen wir aber nicht mal die verallgemeinerte Form der Entropie, sondern es genügt der Speziallfall der "fairen Münzenentropie". Dieser Abschnitt zur Vertiefung ist also Zuende.

1.3 Beispiele und Erläuterungen der Entropie

Wir sind in der Betrachtung unserer Ungewissheit beim (fairen) Münzwurf, auf die Formel

$$M_f=\log_2 K$$

gekommen. Bei einer gleichen Wahrscheinlichkeitsverteilung (also jede einzelne Kombinationsmöglichkeit hat die selbe Wahrscheinlichkeit), wie etwa bei dem Werfen einer fairen Münze, ist es nichts weiter als die logarithmische Betrachtung Der Kombinationsmöglichkeiten. Wir hätten genau so gut die Entropie als die Anzahl der Kombinationsmöglichkeiten definieren können. Die Begründung die Entropie so zu definieren, wie wir es getan haben, hatte damit zu tun, dass wir die Entropie in ungewisser Information in den Einheiten Bits angeben wollten. Man kann aber eine noch einfachere Begründung angeben. Die Kombinationsmöglichkeiten wachsen sehr stark an. Bei 100 Münzwürfen hätten wir beispielsweise $2^{100}=1267650600228229401496703205376$ Kombinationsmöglichkeiten. Mit derart großen Zahlen zu hantieren ist schlichtweg unpraktisch. Wenn ich etwa in der Biologie oder auch der Wirtschaft eine stark anwachsende Funktion betrachten will und dazu ein Schaubild machen will, kann es sinnvoll sein, dieses Schaubild logarithmisch darzustellen. Das ist schlicht übersichtlicher. Diese logarithmische Darstellung ändert aber nichts daran, dass es sich bei der "fairen Münzentropie" schlicht um eine Aussage über die Kombinationsmöglichkeiten handelt.

Was haben aber die Kombinationsmöglichkeiten bei einem Münzwurf damit zu tun, dass sich die Wärme einer Heizung an die kältere Umgebung abgeben wird, aber die kälter Umgebung keine Wärme an die Heizung abgeben kann? Das sollte nach folgendem Abschnitt (hoffentlich) klar sein.

Man stelle sich eine Kiste vor, die in der Mitte eine Trennwand hat. In diese Kiste werfen wir nun kleine Kügelchen entweder links oder rechts rein. Um zu entscheiden ob eine Kugel links oder rechts landet, werfen wir wieder unsere faire Münze. Wenn Kopf kommt werfen wir die Kugel links rein und wenn Zahl kommt, dann rechts. Was uns nun interessiert sind die möglichen Ausgänge des Versuchs und die Wahrscheinlichkeit für einen bestimmten Ausgang. Machen wir etwa 2 Münzwürfe, dann sind die möglichen Ausgänge 2 Kugeln links, 2 Kugeln rechts oder je eine links und rechts. Wenn wir nun wissen wollen, wie die Wahrscheinlichkeit für jede dieser 3 Möglichkeiten ist, dann können wir uns einfach die Kombinationsmöglichkeiten der Münzwürfe ansehen. Werfen wir KK haben wir 2 Kugeln links, werfen wir ZZ haben wir 2 Kugeln links. Werfen wir KZ oder ZK, dann haben wir je eine Kugel auf jeder Seite. Die Wahrscheinlichkeit für jede einzelne Kombinationsmöglichkeit bei diesen 2 Münzwürfen ist $\frac{1}{4}$ und somit ist das auch die Wahrscheinlichkeit für 2 Kugeln links oder 2 Kugeln rechts je $\frac{1}{4}$ bzw 25%. Nun führen aber sowohl die Kombinationen KZ als auch ZK zu je einer Kugel auf jeder Seite. Die Reihenfolge in der wir Kopf oder Zahl werfen, ist also für das Resultat der Kügelchenverteilung egal. Die Wahrscheinlichkeit für diesen Ausgang setzt sich also den Wahrscheinlichkeiten der 2 Kombinationsmöglichkeiten zusammen. Also $\frac{1}{4} + \frac{1}{4} = \frac{1}{2}$ bzw. 50%. Was passiert nun, wenn wir das ganze mit 100 Münzwürfen machen.

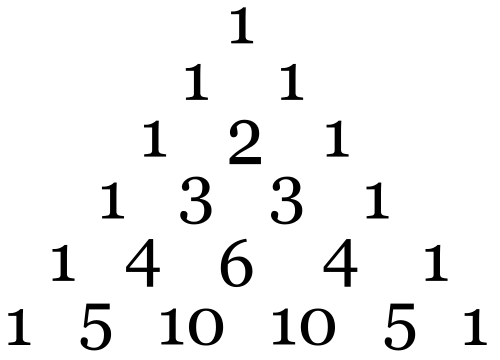

Möchten wir nun sehen, wie sich die Kügelchen bei 100 mit welchen Wahrscheinlichkeiten verteilen, dann wird das eine Lebensaufgabe die ganzen Kombinationsmöglichkeiten der Münzwürfe zu betrachten. Nochmal zu Erinnerung, bei 100 Münzwürfen haben wir 1267650600228229401496703205376 Kombinationsmöglichkeiten. Die ganzen Kombinationsmöglichkeiten aufzuschreiben und zu sehen welche Kombination zu welcher Verteilung der Kügelchen führt, sprengt definitiv den Rahmen dieses Blogbeitrags sowie meiner Lebenszeit. Wie finden wir das also raus? Abhilfe schafft uns Pascal und sein berühmtes Dreieck bzw der Binominalkoeffizient:

|

| Pascalsches Dreieck (Quelle) |

Nehmen wir etwa die dritte Zeile ($1 ~ 2 ~ 1$), dann gibt uns das die Anzahl der Kombinationsmöglichkeiten mit der gleichen Anzahl von Kopf bzw Zahl nach 2 Münzwürfen. $1$ Kombinationsmöglichkeit mit 0 mal Zahl (KK), $2$ Kombinationsmöglichkeit mit 1 mal Zahl (ZK,KZ) und $1$ Kombinationsmöglichkeit mit 2 mal Zahl. Ebenso gibt uns die vierte Zeile ($1 ~ 3 ~ 3 ~ 1$) die Anzahl der Kombinationsmöglichkeiten mit der gleichen Anzahl von Kopf bzw Zahl nach 3 Münzwürfen. $1$ Kombinationsmöglichkeit mit 0 mal Zahl (KKK), $3$ Kombinationsmöglichkeit mit 1 mal Zahl (ZKK,KZK,KKZ), $3$ Kombinationsmöglichkeit mit 2 mal Zahl (ZZK,ZKZ,KZZ) und $1$ Kombinationsmöglichkeit mit 3 mal Zahl (ZZZ)

In der Darstellung mit dem Binomialkoeffizient zu Berechnung der einzelnen Werte sieht das Pascalsche Dreieck so aus:

| Pascalsches Dreieck(Quelle) |

Die obere Zahl in den Klammern ist die Anzahl der Münzwürfe. Die untere Zahl die Anzahl wie oft Zahl (bzw. Kopf) in der Kombination vorkommen soll. Mit $\binom {3}{1}$ kann man etwa berechnen, wieviel Kombinationsmöglichkeiten es nach 3 Würfen gibt in denen 1 mal Zahl vorkommt (vgl. oben).

Also zurück zu unserem Kügelchenversuch. Wenn ich wissen will wie groß die Wahrscheinlichkeit ist, dass nach 100 Würfen je 50 Kügelchen auf jeder Seite sind, können wir nun erstmal berechnen, wieviele Kombinationsmöglichkeiten es nach 100 Würfen gibt, in den genau 50 mal Zahl vorkommt. Also:

$$\binom {100}{50} = \frac{100!}{50! \cdot (100 - 50)!} = 100891344545564193334812497256 $$

Das sind über 100 Quadrilliarden. Das scheint auf den ersten Blick viel zu groß zu sein. Ich zumindest kann mir nicht vorstellen, dass ich aus 50 K's und 50 Z's 100 Quadrilliarden Möglichkeiten habe diese als Reihe (also: KZKZZZK....) zu schreiben. Aber auch wenn ich es mir nicht so Recht vorstellen kann, habe ich gute Gründe der Mathematik zu vertrauen.

Von der Anzahl der Kombinationsmöglichkeiten mit 50 mal Zahl und 50 mal Kopf ist es nun leicht die Wahrscheinlichkeit für alle diese Kombinationen zusammen zu berechnen. Ich muss dazu nur die Anzahl der gerade errechneten Kombinationsmöglichkeiten durch die gesamte Anzahl der Kombinationsmöglichkeiten teilen. Die gesamte Anzahl war $2^{100}$. Also:

$$\frac{100891344545564193334812497256}{2^{100}}= 0{,}07958923738718$$

Wir haben also eine Chance von etwa 8% nach Ende des Versuchs, 50 Kügelchen links und 50 Kügelchen rechts vorzufinden. Betrachten wir die Chance, dass alle Kügelchen links landen, dann sieht man schnell, dass diese viel geringer ist. Im Gegenzug zu den 100 Quadrilliarden an Kombinationen die zu der 50-50 Verteilung führen würden, gibt es nur eine einzige Kombination, bei der alle Kugeln links landen (nämlich: KKKKKKKKK....). Die Chance hierfür ist 1 zu $2^{100}$, also 1 zu einer Quintillion oder 0,000000000000000000000000000079 %.

Das bringt uns nun zurück zur Frage, warum sich die Wärme von der Heizung im Raum verteilt und die Wärme nicht vom Zimmer auf die Heizung übergeht. Dazu kann man sich exemplarisch die Kügelchen aus dem Beispiel gerade, als "Wärmeteilchen" vorstellen. Es gibt schlicht viel mehr Kombinationsmöglichkeiten, dass sich die Teilchen relativ gleichmäßig verteilen, als ungleichmäßig.

Man muss sich aber bei dieser Analogie die Größenordnung vergegenwärtigen. In unserem Beispiel haben wir nur 100 mal die Münze geworfen. In 23g (trockener) Luft haben wir aber ca. 602214129000000000000000 Teilchen (vgl. hier). Außerdem hatten wir bei der Münze nur 2 mögliche "Zustände", nämlich Kopf oder Zahl. Alleine für ein Teilchen haben wir aber 6 Freiheitsgrade (3 Raumrichtungen und 3 Impulsrichtungen) und diese 6 Freiheitsgrade haben keine "diskreten" Werte wie Kopf oder Zahl bzw 0 oder 1, sondern können eine vielzahl von Werten annehmen. Wir hatten schon bei unserem Kügelchenbeispiel eine unvorstellbar große Anzahl von Kombinationsmöglichkeiten. Bei 602214129000000000000000 Teilchen mit 6 Freiheitsgraden sind es Myraden an möglichen Kombinationen.

Das bingt uns nun auch zu der Formel für die Entropie in der statistischen Mechanik:

$$S = k_B \ln \Omega$$

Diese Formel sieht auf den ersten Blick anders aus, als die Formel für die "faire Münzentropie", unterscheidet sich aber nicht wirklich. $\Omega$ bezeichnet das Phasenraumvolumen. Man braucht weder verstehen, was ein Phasenraum, noch was dessen Volumen ist. Das Phasenraumvolumen ist schlicht die Anzahl der möglichen Mikrozustände, also quasi die Anzahl der Kombinationsmöglichkeiten und somit genau das selbe, wie unser $K$ aus der Formel für die "faire Münzentropie". Nun rechnen Physiker die Entropie nicht in Bit, sondern in $\rm \frac{J}{K}$. Rechnet man nicht in Bit, also im Dualsystem ist der natürliche Logarithmus meistens "geschickter" (also $\log_e = \ln$ statt $\log_2$). Die Boltzmann-konstante ist dann nicht mehr als ein Umrechnungsfaktor um von Bit und der Basisumrechnung des Logarithmus auf die Physikalischen Größen zu kommen.

Fassen wir also nochmal zusammen. Die Entropie ist nichts anderes als die logarithmische Betrachtung von Kombinationsmöglichkeiten. Ist die Luft in einem Raum ungleichmäßig verteilt, weil zuvor etwa Wärme durch eine Heizung zugeführt wurde (Heizung ab Beginn der Betrachtung aus damit es ein geschlossenes System ist), gibt es für diesen makroskopischen Zustand der ungleichmäßigen Verteilung weniger mögliche mikroskopische Zustände, als für eine gleichmäßigere Verteilung (oder: Die Entropie ist geringer). Vergleichen wir das nochmal mit den Kügelchen in der Kiste mit der Trennwand, so könnten wir etwa 75 Kügelchen links und 25 Kügelchen rechts haben. Wobei dann diese ungleichmäßige Verteilung der Kügelchen, der ungleichmäßigen Verteilung der Wärme entspricht. Die entsprechenden Kombinationsmöglichkeiten der Münzen wären in diesem Fall dann $\binom {100}{25}$. Die Entropie in Bits wäre also $log_2 {\binom {100}{25}} \approx 78$. Bewegen sich diese Teilchen nun "wild" hin und her, gibt es viel mehr mögliche Bahnen die zu einer gleichmäßigeren Verteilung führen, als zu einer noch ungleichmäßigeren. Es wird sich mit der Zeit eine gleichmäßigere Verteilung einstellen (oder: Die Entropie nimmt zu). Für die absolut gleichmäßige 50-50 Verteilung in dem Kügelchenbeispiel wäre die Entropie in Bits $log_2 {\binom {100}{50}} \approx 96$.

Hier gibt es nur noch drei kleine Anmerkungen zu machen. Zum einen, dass das nichts damit zu tun hat, dass sich die Teilchen "zufällig" bewegen. Der Anfangszustand könnte ganz exakt feststehen und die daraus resultierenden Bahnen sowie ein spätere Zustand ebenso (es kann also vollkommen deterministisch sein). Es ist aber schlicht wahrscheinlicher, dass der spätere Zustand einem der möglichen Zustände der gleichmäßigeren Verteilung entspricht, als der ungleichmäßigeren. Zum anderen ist eine ungleichmäßige Verteilung aber auch nicht gänzlich ausgeschlossen. Es ist theoretisch möglich, dass sich das (kühlere) Zimmer mit der Heizung weiter abkühlt und die Heizung aufgewärmt wird. Das ist nur so dermaßen unwahrscheinlich, dass ein Sechser im Lotto ein Sch.... dagegen ist. Nicht nur das, selbst 1000 mal in Folge, 6 Richtige im Lotto zu haben ist noch um Welten wahrscheinlicher... Ein derartiges Ereignis wäre quasi der Inbegriff des "black swan". Außerdem mag vielleicht noch die Frage auftauchen, wie sich in dem Zimmer überhaupt eine ungleiche Wärmeverteilung durch die Heizung einstellen kann. Wenn die Temperatur im Zimmer gleichmäßig verteilt ist und die Heizung eingeschaltet wird, dann wird die Temperatur ungleichmäßiger verteilt. In diesem Fall nimmt die Entropie im Zimmer in der Tat ab, ABER das ist dann kein geschlossenes System mehr, da durch die Heizung von außen Wärme zugeführt wird. Man müsste dazu die Heizung mit berücksichtigen und dann würde die Entropie insgesamt wieder zunehmen. Ein derartiges Missverständnis findet man etwa bei Kreationisten, die Argumentieren, dass eine höhere Ordnung wie sie durch Leben entsteht dem 2. Hauptsatz der Thermodynamik widersprechen würde. Dabei vergessen sie aber die große Heizung, die sie täglich am Himmel sehen. Nämlich die Sonne. (Das ist aber ein Thema, für das ich eventuell mal einen extra Blogbeitrag schreiben werde.)

Wir haben für obige Betrachtung die Kombinationsmöglichkeiten mit Hilfe des Binominialkoeffizienten betrachtet. Das Pascalsche Dreieck bietet hierzu schon eine brauchbare Anschauung dafür, wie sich die Anzahl der Kombinationsmöglichkeiten für eine immer größere Anzahl von Münzwürfen entwickelt. Ich möchte hierzu noch eine Grafik zeigen, wodurch sich die Zahlen im Pascalschen Dreieck noch besser visualisieren lassen:

|

| Binomialverteilung |

Setzt man das fort, wird bei dieser Darstellung eine Kurve entstehen. Geht die Zahl der Münzwürfe gegen unendlich, dann sieht diese Kurve so aus:

|

| Normalverteilung |

Die Zusammenhänge mit der Normalverteilung möchte ich nicht genau erläutern. Dies soll nur noch Visualisierung dienen.

Und was hat das nun mit Einsteins zerzausten Haaren zu tun? Ganz einfach: Es gibt viel mehr Kombinationsmöglichkeiten für zerzaustes Haar als für gekämmtes (Das Beispiel stammt aus diesem Blogbeitrag. Der Blog ist übrigens generell sehr empfehlenswert).

Und was hat nun die Entropie mit der Gravitation zu tun? Dazu müssen wir erstmal zur Thermodynamik schwarzer Löcher kommen. Das kommt dann in Teil II ...

Ergänzung:

Hier noch ein Video von der Sendung alpha centauri zum Thema Entropie. Darin gibt es auch noch einige schöne Beispiele zu den Kombinationsmöglichkeiten, zur Frage wie Leben/Ordnung überhaupt möglich ist, wenn der 2. HS der Thermodynamik gilt und der Problematik der "Unordnung".

(Quelle Alpha Centauri 152 Was ist Entropie)

Das Beispiel mit dem Mischen der Karten ist auch noch nett. Bei einem Kartenspiel mit 32 Karten gibt es $32! = 263130836933693530167218012160000000 $ Möglichkeiten für eine Anordnung. Die Chance für die geordnete Kombination vom Auspacken ist also 1 zu 263130836933693530167218012160000000. Dann lieber Lotto spielen. Für 6 Richtige (mit Zusatzzahl) ist die Chance 1 zu 139838160.

"… Für die Relativitätstheorie und die Quantenmechanik müssen wir die Vorstellungen des "natürlichen Bewusstseins" von der Beschaffenheit von Raum und Zeit, von der Beschaffenheit der kleinsten Teilchen, aufgeben und uns ganz auf die Gedankengänge (auch in Form mathematischer Formalismen) einlassen…"

AntwortenLöschenO. k. Tun wir es.

"… Stringtheorie hat mit Physik eigentlich nicht mehr wirklich was zu tun, sondern ist eher ein mathematischer Spielplatz in dem Theoretiker - auf dem Kopf gehend - herumtollen und Ideen ausprobieren in der Hoffnung eine "unterlegte" einfachere Theorie zu finden (vgl. M-Theorie)."

Oh, oh,

"... Wer also schon grobe Vorstellungen von Entropie als ein Maß der Unordnung hat, sollte das schleunigst vergessen. "

Eine Empfehlung Deinerseits?

"… Ich denke, dass man Entropie nicht nur mit sehr einfachen Mitteln und Beispielen anschaulich verstehen, sondern dass man sogar die Formel mit Mathematikkenntnissen auf Mittelstufenniveau herleiten kann. …"

Hallo Melethron,

keine Frage. Anschaulichmachen ist gut und das ist Dir auch gut gelungen. Aber Dir sollte schon klar sein, dass Dir mit diesem Ansatz der Kontakt zur Alltagsweltphysik nicht gelingt!

Gegenthese hier:

Im Verlaufe der Evolution eines Systems sucht dieses den ihm bestimmten Endzustand. Dabei besteht in physikalischen Systemen die Triebkraft den Grad an Unordnung zu erhöhen und zu einem bestimmten Endzustand hin zu lenken. Diese „Unordnung“ ist maßgeblich für die nicht mehr verwertbare Energie.

DIES KLAMMERT WAHRSCHEINLICHKEITEN AUS!

Insoweit bestehen natürlich Parallelen zur Entropie, die in einem System unwiederbringlich zunimmt. Die Entropie ist aber erst dann vollständig, wenn der Verbleib der „nicht mehr verwertbaren Energie“ beschrieben ist. Insoweit ist Deine obige Empfehlung, sagen wir mal, sehr mutig.

Wirkung folgt der Triebkraft. Unordnung ist eine Form der Organisation. Keine Organisation ohne Information. Information ist Ursache.

Für diese Elemente reichen die vier Beschreibungsräume der Stringtheorie ebenso wenig aus, wie die der Quantengeometrie (LERN und ITAR grüßen freundlichst).

Aber vielleicht geht es ja einfacher und Hegel meinte hier etwas ganz anderes:

…oder weil dasselbe in der Gewißheit seiner selbst das Prinzip seiner Wirklichkeit hat, trägt sie, indem es für sich außer ihr ist, die Form der Unwirklichkeit…

Ich habe aus Altersgründen schon vor Jahren an dieser Stelle aufgegeben – nicht ohne begriffen zu haben, dass da im Ansatz etwas nicht stimmig sein konnte, was durch ART und QT nur unvollständig beschreibbar war oder nur mit immer wieder neuen Modifikationen. Ich wurde mir der (meiner) Grenzen bewusst und nannte das ganze schließlich Träumerphysik. An dieser Stelle hörte ich auf und schaute mich nach anderen Ansätzen um – 20 bis 30 Jahre zu spät.

Ich wünsche Dir weiterhin gutes Gelingen, werde die Entwicklung aufmerksam verfolgen und erwarte mit Spannung den 2. Teil.

Gruß und alles Gute

0,-

Hey 0,-

Löschendeine Gegenthese finde ich nicht sehr überzeugend. Das ist vergleichbar zu sagen, dass es die Bestimmung beim Lottospielen ist, zu verlieren und dass dich eine Kraft dazu drängt falsch zu tippen. Nicht die vielen Kombinationsmöglichkeiten sind die Ursache, dass die getippten Zahlen höchstwahrscheinlich nicht mit den gezogenen Zahlen übereinstimmen, sondern die Bestimmung zu verlieren ist es. Wahrscheinlichkeitsrechnung und Kombinatorik finde ich hier und bei der Entropie überzeugender.

Was deine Bemerkung zu ART und QM angeht. Da hast du vollkommen Recht. Der Ansatz für ART und QM kann nicht stimmen, denn sonst gäbe es keine Widersprüche. Diese zwei Theorien sind aber deswegen nicht wirklich falsch, sondern stellen wohl eher Spezialfälle eines anderen Ansatzes dar. Solange man keinen anderen Ansatz (oder auch ein anderes Paradigma) hat, der mindestens genau so viel erklärt, macht es aber Sinn diese Theorien weiter zu verwenden und eben durch solche Modifikation wie der Stringtheorie nach Gemeinsamkeiten zu suchen. Das es Indizien für solche Gemeinsamkeiten (AdS/CFT Korrespondenz, Thermodynamik schwarzer Löcher) gibt, habe ich schon in der anderen Antwort auf dein Kommentar erwähnt und das wird in dieser Artikelserie noch sehr genau thematisiert.

Der Ansatz Newtons, Raum und Zeit als absolut anzunehmen, war natürlich falsch. Dennoch ist seine Theorie eine gute Näherungslösung für die bessere Theorie von Einstein bei v<<c . ART und QM sind auch nichts als Näherungslösungen einer G.U.T. (sofern es eine solche gibt und man sie auch finden kann).

Ich selber glaube auch nicht, dass die Stringtheorie wirklich zu einer adäquaten Beschreibung der physikalischen Vorgänge taugt. Dennoch kann sie hilfreich sein eine besseren Ansatz zu finden.

Einen schönen Vergleich dazu gibt es bei der Epizykeltheorie (http://de.wikipedia.org/wiki/Epizykeltheorie). Da hat man auch ewig versucht die beobachteten Planetenbahnen durch eine Modifikation des geozentrischen Weltbilds zu zu erklären. Ohne diese Epizykel hätte aber Kopernikus den Paradigmenwechsel zum heliozentrischen Weltbild wohl nicht geschafft. Auch er hat (wegen der Annahme die Bahnen seien kreisrund) diese Epizykel gebraucht. Ohne diese Theorie. wäre er vielleicht nie zu seiner Theorie gekommen und ohne seine Theorie wohl auch Kepler nicht auf seine. Diese Modifikation des falschen Ansatzes, haben also bei der Entwicklung des richtigen Ansatz geholfen. Vielleicht wäre man auch auf anderem Weg zum heliozentrischen Weltbild gelangt, aber die Epizykeltheorie hat diesen Weg dennoch vereinfacht. Aus diesem Grund würde ich Modifikationen nicht per se abschreiben.

Die Physik lechzt gerade zu nach einem neuen Paradigma, aber Paradigmen fallen nicht vom Himmel. Aus diesem Grund lieber erst einmal "Träumerphysik" und Erweiterungen, denn es kann gut sein, dass diese vielleicht helfen, ein neues Paradigma zu finden.

Zu der Meinung, dass die Physik nicht ganz auf dem Holzweg ist, wirst du vielleicht im Laufe der Artikelserie auch noch kommen, wenn wir uns an den Rand des Ereignishorizonts eines schwarzen Loches begeben und es dort auf einmal kuriose (???) Gemeinsamkeiten bei QM,ART und Thermodynamik gibt.

Grüße

melethron

Als Ergänzung möchte ich noch die Karlsruher Artikelreihe "Altlasten der Physik" (http://www.physikdidaktik.uni-karlsruhe.de/altlast/) empfehlen. Dort wird gut nachvollziehbar versucht, die thermodynamisch schwer fassbare Entropie auf die auch für Schüler anschaulich fassbare Wärme bzw. Wärmemenge zu projizieren (http://www.physikdidaktik.uni-karlsruhe.de/altlast/8.pdf, http://www.physikdidaktik.uni-karlsruhe.de/altlast/54.pdf, http://www.physikdidaktik.uni-karlsruhe.de/altlast/II07.pdf..).

AntwortenLöschenDen Erwartungswert des Informationsgehaltes eines Zeichens eines Alphabets bei der Informationsverarbeitung hätte Shannon vielleicht lieber "Ungewissheit" nennen sollen, dann wären einige Verwirrungen unterblieben. Aber Herr von Neumann hatte anscheinend ein Talent dafür, physikalische Modelle zu verkomplizieren....

Viele Grüße

Rüdiger

Hey Rüdiger,

Löschennur durch die Namensgebung, wird das Modell nicht komplizierter. Desweiteren heißen die Entropien nicht nur gleich, sondern SIND das selbe. Der Unterschied ist nur die Einheiten. Gebe ich die physikalische Entropie in Bits an (Umrechnung durch Multiplikation mit $\frac {k_B}{\log_2 e}$) ist das dann die Menge an Information die bei Kenntnis des Makrozustands über den Mikrozustands fehlt. Wie eng das Ganze zusammenhängt, wird hoffentlich auch noch klarer, wenn ich im nächsten Teil über die Thermodynamik schwarzer Löcher und das holografische Prinzip schreibe.

Grüße

melethron

Natürlich ist es das gleiche Modell, aber die modellierten Systeme sind doch verschieden.

LöschenIch wollte nur darauf hinweisen, zwischen Beschreibung und Realität zu unterscheiden.

Vielen Dank und viele Grüße

Rüdiger

Hallo Melethron,

AntwortenLöschen"...Wahrscheinlichkeitsrechnung und Kombinatorik finde ich hier und bei der Entropie überzeugender.“

Das reicht aber nicht, denn die Entropie ist nicht Selbstzweck der Physik(er). Am Ende bleibt immer noch die Bilanzierung der „nicht mehr verwertbaren Energie“ offen. Ich denke, wenn man den Zustand beschreiben will, kommt man nicht mit der Bestimmung der Grenzen aus. Solange die Entropie nicht sein Maximum erreicht hat, gibt es kein Gleichgewicht.

Alles was außerhalb dieses Gleichgewichtes passiert wurde seinerzeit von Lars Onsager sehr überzeugend dargelegt.

Wenn man aber davon aus geht, dass eine Entropieproduktion erfolgt, muss es also bis zum Erreichen des Gleichgewichtszustandes innerhalb des Systems freie Energie geben – es sei denn, dass System ist NICHT geschlossen. Aber das hat Konsequenzen für die Gültigkeit der TD-Sätze und ihrer Postulate. Und darauf bezieht sich mein Einwurf. Ein Widerspruch ergibt sich schon dann, wenn man vom Urknall ausgehend auf offene Systeme schließt.

Die Einschränkung offenes vs. geschlossenes System steht aber auch hier einem universell geltenden Gesetz entgegen – ist also ebenfalls unvollständig. Unvollständig plus unvollständig ist nicht zwingend vollständig – siehe Onsager.

Statische Betrachtungen sind schließlich immer nur ein Element dynamischer Prozesse an einem konkreten (Zeit)Punkt. Welchen wählen wir aus?

Nur mal so: Wie wäre es denn mal mit einem periodisch expandierenden und kontrahierenden geschlossenen Raum? Das wären doch wohl zeitliche Flüsse die immer wieder einen Anfangszustand durchlaufen, also einem geometrischen Verdichtungszustand folgen (versimplifiziert in etwa einem Luftballon in mehr oder weniger Wärme).

Ja, was macht denn dann unsere Entropie?

Ist sie dann immer noch irreversibel?

Mathematik oder Physik?

Alles Gute

0,-

Nur mal so: Hast du dir jemals einen Kreisprozess angesehen?

LöschenWas passiert denn, wenn die Entropie etwa bei einer isothermen Kompression abnimmt?

Teste es doch einfach. Besorg dir einfach einen Stirlingsmotor (der Kolben ist in einem abgeschlossenen Raum) und anstatt den mit Wärme anzutreiben, nimm ne Bohrmaschine und lass den abgeschlossen Raum damit expandieren und kontrahieren. Die Entropie bleibt innerhalb des geschlossenen Raums nach einem vollen Zyklus gleich. Und außerhalb? Nicht die Finger verbrennen beim Testen ;-)

Ja, was macht denn dann unsere Entropie?

Ist sie dann immer noch irreversibel?

Ja klar. Wieso denn nicht?!

Hallo Melethron,

Löschenich denke, dieser Beitrag steht soweit hinten, dass eine gewisse Wahrscheinlichkeit gegeben ist, dass ihn kaum noch jemand lesen wird.

Ansonsten kannst Du ihn auch bedenkenlos löschen.

Es liegt zwar nun schon etwas länger zurück - ich glaube, Bill Gates ging damals noch zur Schule - seit ich jemanden kenne, der seinerzeit bei Brown, Boverie & Cie zwischendurch immer die große Tafel abwischte.

Das sollte genügen, mir Oberflächlichkeit, Unkenntnis und sogar fehlende Erfahrung unterstellen zu dürfen, soweit es um Fragen der Theoretischen Physik, etwa der Thermodynamik geht und ihre Anwendbarkeit in Ingenieurwissenschaften mit Bezug auf Systeme, die nicht nur möglichst genaue Vorhersagen über zu erwartende Endzustände verlangten, sondern auch die Beschreibungen der dazugehörigen aktiven Prozesse erforderten.

Dennoch darfst Du mir zumuten zwischen staunendem Verstehen und gläubigen Aufschauen unterscheiden zu können.

In diesen Grenzen sind mir auch im Ansatz die inhaltlichen Bezüge von Physik und Chemie im Sinne von Verbrühen und Verbrennen durchaus nicht fremd.

Ich kann mich auch noch erinnern, dass bei einer isothermen thermodynamischen Zustandsänderung – egal ob Kompression oder Expansion die Temperatur unverändert bleibt und ein Kreisprozess ein jederzeit umkehrbarer Prozess mit Entropie gleich Null ist. Ja klar, unverändert kann auch ziemlich heiß sein. Aber vielleicht meintest Du die adiabatischen Kompression, die im Wechsel mit einer Dekompression zwar in einem zyklischen Prozess läuft, in etwa wie bei einer Carnot-Maschine, wo die Entropie insgesamt eine Rolle spielen kann, wenn der Prozess nicht zufällig isentrop abläuft. Dies sind aber nur ein paar Spezialfälle. Tatsächlich gibt es nur Zustandsänderungen polytroper Art, die alle Spezialfälle als Idealisierungen einschließen und die nacheinander oder gleichzeitig auftreten können, denn in der Realität ist nichts konstant. Leider.

Ich hoffe, Deine erste Frage insoweit erschöpfend beantwortet zu haben und mahne unbedingt zur Vorsicht bei der Kopplung einer Bohrmaschine an den Stirlingmotor! Nicht mit den Fingern an den Stecker kommen. Könnte schließlich Strom drin sein. ;-)

„…Ansonsten dürfte ich das Niveau halten können.“

O.k. ich auch.

Eigentlich könnten wir noch ewig weiter theoretisieren, um dissipative Strukturen, um Bénard-Zellen und um Klimafragen usw. Das sollte die Entropie ja wohl hergeben! Schließlich wird ja auch ohne Kosten und Mühen zu scheuen seit Jahren versucht, jenseits der geometrisierbaren Fläche aus dem Quadrat der Planckschen Länge eine sinnvolle Physik zu erfinden, um die allerletzte Frage der letzten Fragen zu klären, um schließlich die allerallerletzte Frage ...

Oh ja, da steht noch jede Menge Reputation in Aussicht und es gibt noch auf Jahre hinaus viel Forschungsgeld abzufassen. Das kann nicht falsch sein. Dafür habe ich vollstes Verständnis. Natürlich auch für angehende Lehrer oder Journalisten.

Blogs und Chats sind nix für Leute mit nachlassender Grauzellenbeweglichkeit. Stammtisch, Fitnesscenter und Seniorenakademie sind da einfach besser – da man kann reden und streiten und philosophieren ohne Ende.

Gruß und alles Gute und viel Erfolg

Das wars.

0,-

Hey 0,-

Löschenich habe absolut gar nichts gegen reden, streiten und philosophieren und ich weiß auch nicht wie du darauf kommst, dass ich dein Kommentar löschen sollte.

Was mir nicht klar ist, ist die Frage zum zyklisch kontrahierenden und expandierenden Raum, wenn du doch gute Kenntnisse in Thermodynamik hast. Hast du eine Kontraktion der Raumzeit selber gemeint. In diesem Sinne ist diese Frage durchaus interessant (auch wenn ich sie als metaphysische und nicht als physikalische Frage auffassen würde - und als großer Hegel Fan ist Metaphysik übrigens keineswegs abwertend gemeint). In diesem Fall könnte die Entropie in der Tat umkehrbar sein, ... oder aber der Zeitpfeil dreht sich um.

In unserem Universum werden wir das mit immer weiter zunehmender Rotlichverschiebung wohl nie erfahren. Ich aber würde zugunsten der Mathematik aber eher auf die Zeitumkehr tippen, das aber nur weil ich Logik und Mathematik für universell (über unser Universum hinaus) halte. Das ist aber wohl eine Wunschvorstellung, die meiner Zuneigung zum Idealismus entspringt.

Grüße

melethron

Hallo melethron,

LöschenPerlmutter, Schmidt und Riess hatten kürzlich festgestellt, dass die Expansion des Universums heute beschleunigt abläuft, was wörtlich genommen aus der kosmologischen Konstante eine Variable macht. Sie nehmen als Ursache der Beschleunigung Dunkle Energie an, was n.m.M. einem Eingeständnis gleichkommt. Ich werde mich hüten, dies zu kommentieren.

Wenn die Feststellung einer beschleunigten Expansion stimmt, kann man auf das Äußerste simplifizierend genauso den zeitlichen Verlauf ähnlich einer Kosinusfunktion annehmen, die nach dem Erreichen der maximalen Expansion mit zunehmender Geschwindigkeit einem Umkehrpunkt zuläuft. Dies könnte einerseits eine zunehmende Rotverschiebung erklären, andererseits einen immerwährenden natürlichen Zyklus beschreiben, der am Anfang zwar einen Punkt Null hat, aber ab da ohne einen Urknall auskommt und an beliebiger Stelle starten kann. Dies macht eine „Zeitumkehr“ unnötig und auch die Frage nach dem „davor“, denn die Zeitinvarianz wird von der Energieerhaltung erzwungen und nicht vom Energieursprung.

Das Minimum einer Strukturverdichtung steht dem Maximum einer anderen Struktur gegenüber. Minimum und Maximum tauschen sich periodisch aus. Dieser Austausch hat nach innen und nach außen gerichtete Komponenten im Sinne eines korrelierenden Wechselwirkungsprozesses nach innen und einem gleichzeitig korrespondierenden Prozess nach außen. In seinem Maximum ist die Korrelation durch die Superposition immer ein kleiner pseudoeuklidischer Bereich.

Es ergibt sich ein veränderlicher zeitlicher Fluss, der dem Charakter einer Spirale entspricht. Dies geht einher mit dem physikalischen Grundgesetz, dass es keine abgeschlossenen Prozesse geben kann. Insoweit könnte auch die beobachtete Beschleunigung passen.

Aber wie Eingangs eingeschränkt ist eben das eine eigentlich unzulässige Vereinfachung.

Die Hypothese vom Urknall fordert die abnehmende Fluchtgeschwindigkeit des Universums als alleinige Ursache der Rotverschiebung. Das passt nicht mehr, wenn es noch andere Wechselwirkungsmechanismen zwischen Licht und Materie gibt, die ebenfalls zur Rotverschiebung führen, wie Marmet schließlich nachweisen konnte.

Zwicky, Hubble und Reber boten schon Mitte des vergangenen Jahrhunderts an, dass Licht wegen der Wechselwirkungen proportional zu der zurückgelegten Entfernung scheinbar Energie verliert, sich also verlangsamt. Man müsste mal gucken, wie sich diese Beobachtungen erklären ließen und wo der Widerspruch zu Perlmutter, Schmidt und Riess hinführt, wenn es ihn denn überhaupt gibt.

Es scheint in Folge verschiedener Ursachen für die Rotverschiebung derzeit kein konsistentes kosmologisches Modell zu geben. Dies ist jedoch entscheidend für Sinn und Gültigkeit, denn das Modell muss auch für den Mikrokosmos gelten – also universell sein. Derzeit scheinen jedoch alle falsch oder unvollständig …

Nur mal so. Kann es nicht sein, dass ein Trugschluss am Anfang war, aus dem man einen Zusammenhang zwischen der Rotverschiebung kosmischer Objekte und einer Expansion des Universums konstruierte und die Dinge möglicherweise gar nichts miteinander zu tun haben?

Gruß und alles Gute

0,-

Energieabhängige Lichtgeschwindigkeit war auch der Ansatz den John Ellis verfolgt hat. Mit den Daten von GLAST kann man das aber mittlerweile getrost streichen.

Löschenhttp://www.space.com/7461-space-time-observations-find-einstein-rules.html

Aber mal eine ganz andere Überlegung. Wenn sich die Raumzeit (samt Gravitation) emergent aus der Entropiezunahme ergibt, folgt eine exponentielle Expansion der Raumzeit quasi trivial. Das Tolle ist, dass diese sogar sehr exakt zur Rotlichtverschiebung passt. Das alles kommt in Teil III zur entropic gravity. Mit Verlinde könnte man die dunkle Energie streichen.

Darüber hinaus arbeitet Verlinde gerade an einer Herleitung der "Tully-Fischer relation" (http://de.wikipedia.org/wiki/Tully-Fisher-Beziehung) aus einer Überführung aus dem Higgs-branch (gravitation) aus dem Culomb-branch ("Rest") der M-Theorie. Also Tschüss, Dunkle Materie.

Das kommt in Vorlesung III ab ca 50:00

http://www.youtube.com/watch?v=yk_Yy6TqgJs

http://www.youtube.com/watch?v=iReASE_rhHA

http://www.youtube.com/watch?v=pg_mm4wXXq0

Leider fällt der Ton aus und die Herleitung fehlt, daher bin ich sehr gespannt auf sein nächstes paper.

Entropie in einer CFT + Hologravie = Raumzeit + Gravitation (ohne Dunkle Materie) + Expansion des Universums (ohne dunkle Energie)

Sieht ganz schön vielversprechend aus, oder?!

Wie gesagt, Verlinde dann in Teil III.

Übrigens: Die Tully Fischer Beziehung ist in meinen Augen sowieso schon der Hinweis, das Dunkle Materie nichts weiter als die "Epizykel" der ART sind und von Dunkle Energie kannst du gern auch kommentieren - ich halt auch nix davon ;-). Epizykel halt. (Aber Kopernikus hätte ohne Epizykel vielleicht auch nicht den Sprung geschafft - der gedankliche Sprung zu Kepler ist größer, daher haben auch Epizykel im Fortgang der Wissenschaft ihre Berechtigung),

Grüße

melethron

Hi melethron,

AntwortenLöschenDu solltest bei dem Beispiel mit den Kügelchen erwähnen, dass diese UNTERSCHEIDBAR sein müssen (also z.B. numeriert). Wenn es einfach alles weiße Kügelchen sind, ist die Anzahl der Kombinationen VIEL geringer, nämlich exakt 100 :) Die Wahrscheinlichkeit für das Extrem "100 & 0" bleibt gleich, alle anderen werden viel höher.

Gruß yoobee.

PS: Danke für die Anregung zu Verlinde & Co.!

Hey yoobee,

Löschendie Kügelchen brauch ich deshalb nicht nummerieren, weil ich ja die Kombinationen der Münzwürfe betrachtet habe. Ich hab es zwar nicht explizit erwähnt, aber ich denke das es klar ist, dass ich dort bei möglichen Kombinationen, die Kombinationen in der Reihefolge, wie sie nach dem Werfen auftreten, gemeint habe. Dadurch habe ich ja eine Nummerierung.

Danke für das aufmerksame Lesen, ich werd nochmal einen Blick drauf werfen, um zu sehen, das es auch wirklich klar ist, dass die Kombinationen in der auftretenden Reihenfolge gemeint sind.

Grüße

melethron

Hab es nochmal explizit in den Artikel rein geschrieben. Danke nochmal.

LöschenDanke für diesen wundervollen Artikel!

AntwortenLöschenK.S.